Topik ini menjelaskan catatan rilis untuk training-nv-pytorch 25.12.

Fitur utama dan perbaikan bug

Fitur utama

vLLM ditingkatkan ke versi 0.12.0, dan flashinfer-python ditingkatkan ke versi 0.5.3.

Perbaikan bug

Tidak ada.

Isi

Nama citra | training-nv-pytorch | |

Tag | 25.12-cu130-serverless | 25.12-cu128-serverless |

Skenario | Pelatihan/Inferensi | |

Framework | PyTorch | |

Persyaratan | NVIDIA Driver release >= 580 | NVIDIA Driver release >= 575 |

Arsitektur yang didukung | amd64 & aarch64 | amd64 |

Komponen inti |

|

|

Aset

Citra publik

CUDA 13.0.2 (Driver >= 580, amd64 & aarch64)

egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/training-nv-pytorch:25.12-cu130-serverless

CUDA 12.8 (Driver >= 575, amd64)

egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/training-nv-pytorch:25.12-cu128-serverless

Citra VPC

Untuk mempercepat pengambilan citra kontainer AI ACS dari dalam VPC, ganti URI aset egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/{image:tag} dengan acs-registry-vpc.{region-id}.cr.aliyuncs.com/egslingjun/{image:tag}.

{region-id}: ID wilayah wilayah yang tersedia tempat Produk ACS Anda berada. Contohnya,cn-beijingdancn-wulanchabu.{image:tag}: Nama dan tag citra kontainer AI. Contohnya,inference-nv-pytorch:25.10-vllm0.11.0-pytorch2.8-cu128-20251028-serverlessdantraining-nv-pytorch:25.10-serverless.

Citra ini cocok untuk Produk ACS dan produk multi-penyewa Lingjun. Citra ini tidak cocok untuk produk single-penyewa Lingjun. Jangan menggunakannya dalam skenario single-penyewa Lingjun.

Persyaratan driver

Rilis 25.12 mendukung CUDA 12.8.0 dan CUDA 13.0.2 berdasarkan versi driver yang berbeda. CUDA 13.0.2 memerlukan versi driver NVIDIA 580 atau lebih baru. CUDA 12.8.0 memerlukan versi driver NVIDIA 575 atau lebih baru. Untuk daftar lengkap driver yang didukung, lihat topik CUDA Application Compatibility. Untuk informasi selengkapnya, lihat CUDA Compatibility and Upgrades.

Fitur dan peningkatan utama

Optimasi kompilasi PyTorch

Fitur optimasi kompilasi yang diperkenalkan di PyTorch 2.0 cocok untuk pelatihan skala kecil pada satu GPU. Namun, pelatihan LLM memerlukan optimasi Memori GPU dan framework terdistribusi, seperti FSDP atau DeepSpeed. Akibatnya, torch.compile() tidak memberikan manfaat bagi pelatihan Anda atau bahkan dapat berdampak negatif.

Mengontrol granularitas komunikasi dalam framework DeepSpeed membantu kompilator memperoleh graf komputasi lengkap untuk cakupan optimasi kompilasi yang lebih luas.

PyTorch yang dioptimalkan:

Antarmuka depan kompilator PyTorch dioptimalkan untuk memastikan kompilasi tetap berjalan meskipun terjadi gangguan graf pada graf komputasi.

Kemampuan pencocokan mode dan bentuk dinamis ditingkatkan untuk mengoptimalkan kode hasil kompilasi.

Setelah optimasi tersebut, throughput E2E meningkat sebesar 20% saat melatih model LLM 8B.

Optimasi Memori GPU untuk recomputation

Kami memprediksi dan menganalisis konsumsi Memori GPU model dengan menjalankan pengujian kinerja pada model yang diterapkan di kluster berbeda atau dikonfigurasi dengan parameter berbeda serta mengumpulkan metrik sistem, seperti pemanfaatan Memori GPU. Berdasarkan hasil tersebut, kami merekomendasikan jumlah optimal lapisan recomputation aktivasi dan mengintegrasikannya ke dalam PyTorch. Hal ini memungkinkan pengguna memperoleh manfaat optimasi Memori GPU secara mudah. Saat ini, fitur ini tersedia dalam framework DeepSpeed.

Evaluasi manfaat kinerja E2E

Menggunakan tool evaluasi dan analisis kinerja AI cloud-native CNP, kami melakukan perbandingan kinerja end-to-end yang komprehensif. Kami menggunakan model open source utama dan konfigurasi framework terhadap citra dasar standar. Kami juga melakukan eksperimen ablation untuk mengevaluasi kontribusi setiap komponen optimasi terhadap kinerja pelatihan model secara keseluruhan.

Perbandingan citra: Citra dasar dan evaluasi iterasi

Analisis kontribusi kinerja E2E komponen GPU inti

Pengujian berikut didasarkan pada versi 25.12. Pengujian ini menunjukkan evaluasi dan perbandingan kinerja E2E untuk pelatihan pada kluster GPU multi-node. Item perbandingan meliputi:

Base: NGC PyTorch Image

ACS AI Image: Base+ACCL: Citra ini menggunakan library komunikasi ACCL.

ACS AI Image: AC2+ACCL: Citra ini menggunakan AC2 BaseOS tanpa optimasi yang diaktifkan.

ACS AI Image: AC2+ACCL+CompilerOpt: Citra ini menggunakan AC2 BaseOS dengan hanya optimasi torch compile yang diaktifkan.

ACS AI Image: AC2+ACCL+CompilerOpt+CkptOpt: Citra ini menggunakan AC2 BaseOS dengan optimasi torch compile dan selective gradient checkpoint yang diaktifkan.

Quick start

Contoh berikut menunjukkan cara menarik citra training-nv-pytorch menggunakan Docker.

Untuk menggunakan citra training-nv-pytorch di ACS, Anda dapat memilihnya dari halaman Artifacts di Konsol saat membuat workload, atau menentukan referensi citra dalam file YAML.

1. Pilih citra

docker pull egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/training-nv-pytorch:[tag]2. Panggil API untuk mengaktifkan kompilator dan recomputation guna optimasi Memori GPU

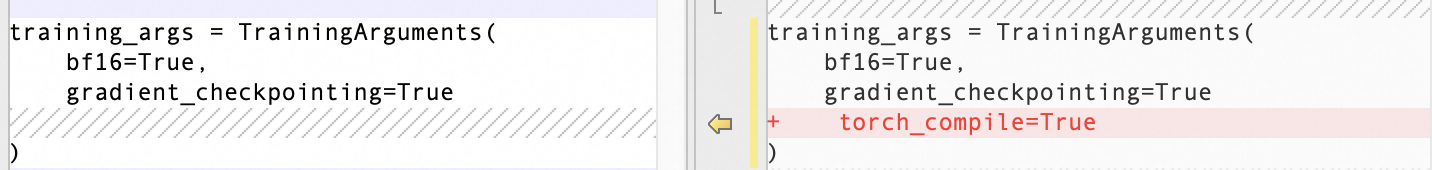

Aktifkan optimasi kompilasi

Gunakan API transformers Trainer:

Aktifkan recomputation untuk optimasi Memori GPU

export CHECKPOINT_OPTIMIZATION=true

3. Mulai kontainer

Citra ini mencakup tool pelatihan model bawaan bernama ljperf. Langkah-langkah berikut menunjukkan cara menggunakan tool ini untuk memulai kontainer dan menjalankan pekerjaan pelatihan.

Kelas LLM

# Mulai dan masuk ke kontainer

docker run --rm -it --ipc=host --net=host --privileged egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/training-nv-pytorch:[tag]

# Jalankan demo pelatihan

ljperf benchmark --model deepspeed/llama3-8b 4. Rekomendasi

Perubahan dalam citra ini melibatkan library seperti PyTorch dan DeepSpeed. Jangan menginstal ulang library tersebut.

Biarkan zero_optimization.stage3_prefetch_bucket_size dalam konfigurasi DeepSpeed kosong atau atur ke auto.

Variabel lingkungan bawaan

NCCL_SOCKET_IFNAMEdalam citra ini harus disesuaikan secara dinamis berdasarkan skenario:Saat satu Pod meminta 1, 2, 4, atau 8 kartu untuk tugas pelatihan atau inferensi, atur

NCCL_SOCKET_IFNAME=eth0. Ini adalah konfigurasi default dalam citra ini.Saat satu Pod meminta semua 16 kartu pada satu mesin untuk tugas pelatihan atau inferensi, Anda dapat menggunakan High-Performance Network (HPN). Atur

NCCL_SOCKET_IFNAME=hpn0.

Isu yang diketahui

Mengompilasi fa3 secara langsung pada citra CUDA 13.0.2 menyebabkan error. Ini merupakan isu komunitas yang diketahui.