Topik ini menjelaskan catatan rilis untuk training-nv-pytorch 25.06.

Fitur utama dan perbaikan bug

Kerangka kerja yang diperbarui

PyTorch dan komponen terkait ditingkatkan ke V2.7.1.8.

Triton Inference Server ditingkatkan ke V3.3.0.

Kompatibilitas versi vLLM ditingkatkan untuk mendukung 0.9.1.

Menambahkan dukungan untuk arsitektur GPU Blackwell NVIDIA, memungkinkan pengembangan berorientasi masa depan pada perangkat keras generasi berikutnya.

Perbaikan bug

Memperbaiki efisiensi optimalisasi video random access memory (VRAM) yang menurun dalam gambar kontainer lama dengan meningkatkan PyTorch ke V2.7.1.8.

Detail citra

Skenario | Pelatihan/Inferensi |

Kerangka kerja | PyTorch |

Persyaratan driver | NVIDIA Driver ≥ 575 (lihat di bawah untuk kompatibilitas GPU pusat data) |

Komponen inti |

|

Citra tersedia

V25.06

Citra publik: egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/training-nv-pytorch:25.06-serverless

Citra VPC

acs-registry-vpc.{region-id}.cr.aliyuncs.com/egslingjun/{image:tag}

{region-id}: Wilayah tempat Alibaba Cloud Container Compute Service (ACS) Anda diaktifkan (contoh: cn-beijing, cn-wulanchabu).{image:tag}: Nama citra dan tag.

Penarikan citra VPC saat ini hanya didukung di wilayah China (Beijing).

Citra ini cocok untuk kluster ACS dan kluster multi-penyewa Lingjun, tetapi tidak didukung pada kluster single-penyewa Lingjun.

Persyaratan driver

Rilis V25.06 didasarkan pada CUDA 12.8.0 dan memerlukan NVIDIA Driver 575 atau lebih baru. Untuk GPU pusat data (seperti T4), versi driver berikut kompatibel:

470.57+ (cabang R470)

525.85+ (cabang R525)

535.86+ (cabang R535)

545.23+ (cabang R545)

Penting: Paket kompatibilitas driver CUDA hanya mendukung cabang driver tertentu. Pengguna pada cabang yang tidak kompatibel (R418, R440, R450, R460, R510, R520, R530, R545, R555, R560) harus melakukan peningkatan, karena mereka tidak memiliki kompatibilitas maju dengan CUDA 12.8. Untuk detail lengkap, lihat Kompatibilitas CUDA dan Kompatibilitas dan Peningkatan CUDA.

Fitur utama dan peningkatan

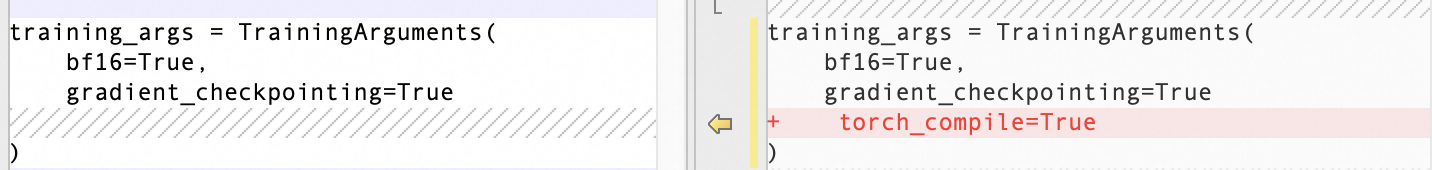

PyTorch kompilasi optimisasi

Meskipun torch.compile() memberikan peningkatan kinerja yang kuat dalam skenario single-GPU, manfaatnya terbatas dalam pelatihan LLM berskala besar karena kerangka kerja terdistribusi seperti FSDP dan DeepSpeed.

Untuk membuka optimalisasi kompiler yang lebih luas:

Kami mengoptimalkan granularitas komunikasi dalam DeepSpeed, mengekspos grafik komputasi yang lebih besar dan lebih koheren kepada kompiler.

Meningkatkan antarmuka depan kompiler untuk menangani pemutusan grafik arbitrer.

Meningkatkan pencocokan pola dan dukungan bentuk dinamis untuk performa kompilasi yang stabil.

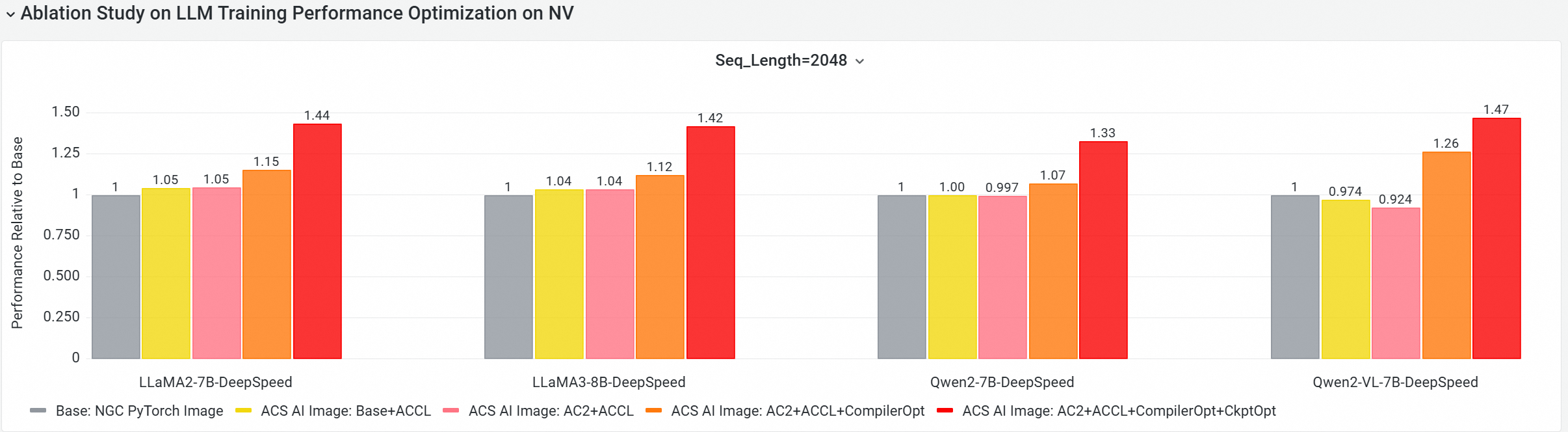

Hasil: Peningkatan throughput end-to-end (E2E) sebesar ~20% yang konsisten dalam pelatihan LLM dengan 8B parameter.

Optimalisasi checkpoint gradien

Melalui benchmarking ekstensif di seluruh model, konfigurasi kluster, dan metrik sistem (termasuk pemanfaatan memori), kami mengembangkan model prediktif untuk mengidentifikasi lapisan rekomputasi aktivasi yang optimal. Optimalisasi ini sekarang terintegrasi secara native ke dalam PyTorch dan didukung di DeepSpeed, memungkinkan adopsi teknik optimalisasi memori tingkat lanjut dengan usaha rendah.

ACCL

Alibaba Cloud Communication Library (ACCL) adalah rangkaian pustaka jaringan berkinerja-tinggi (HPN) yang dirancang untuk Lingjun.

Salah satu komponen utamanya adalah ACCL-N, pustaka komunikasi yang dipercepat GPU yang disesuaikan dari NVIDIA Collective Communications Library (NCCL). Sambil mempertahankan kompatibilitas API penuh dengan NCCL, ACCL-N menyediakan beberapa peningkatan:

Peningkatan Kinerja: Memberikan throughput yang jauh lebih tinggi dan stabilitas yang lebih besar, terutama dalam lingkungan pelatihan berskala besar, multi-node.

Peningkatan Stabilitas: Termasuk perbaikan bug yang ditargetkan yang belum tersedia di versi NCCL standar.

Evaluasi peningkatan performa E2E

Menggunakan alat analisis performa AI Platform Cloud Native (CNP), kami melakukan perbandingan E2E komprehensif terhadap citra dasar standar (seperti NGC PyTorch). Tes menggunakan model open-source utama dan kerangka kerja, dengan studi ablasi untuk menghitung kontribusi setiap optimalisasi.

Konfigurasi Tes (Kluster GPU Multi-Node)

Kasus Uji | Konfigurasi |

1. Baseline | NGC PyTorch Image |

2. ACS AI Image: Base + ACCL | Citra dasar dengan pustaka komunikasi ACCL |

3. ACS AI Image: AC2+ACCL | Citra Golden dengan AC2 BaseOS (tanpa optimalisasi) |

4. ACS AI Image: AC2 + ACCL + CompilerOpt | AC2 BaseOS dengan optimalisasi |

5. ACS AI Image: AC2 + ACCL + CompilerOpt + CkptOpt | AC2 BaseOS dengan torch compile dan selektif gradient checkpointing |

Memulai cepat

Contoh ini menggunakan Docker untuk menarik dan menjalankan citra training-nv-pytorch.

Untuk pengguna ACS: Saat menerapkan di ACS, pilih citra dari Artifact Center di Konsol atau tentukan dalam konfigurasi YAML Anda.

1. Tarik citra

docker pull egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/training-nv-pytorch:[tag]2. Aktifkan kompiler dan optimalisasi memori

Optimalisasi Kompilasi dengan Transformers Trainer API

Aktifkan Optimalisasi Checkpoint Gradien

export CHECKPOINT_OPTIMIZATION=true

3. Jalankan kontainer

Citra tersebut mencakup alat pelatihan bawaan: ljperf.

Contoh pelatihan LLM

# Mulai kontainer

docker run --rm -it --ipc=host --net=host --privileged egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/training-nv-pytorch:[tag]

# Jalankan demo pelatihan

ljperf benchmark --model deepspeed/llama3-8b 4. Rekomendasi penggunaan

Jangan instal ulang PyTorch, DeepSpeed, atau pustaka terkait—citra tersebut mencakup binari yang telah dioptimalkan sebelumnya.

Dalam konfigurasi deepspeed, biarkan

zero_optimization.stage3_prefetch_bucket_sizekosong atau atur keauto.Citra tersebut mengatur pra-set

NCCL_SOCKET_IFNAME:Saat pod tunggal meminta 1/2/4/8 kartu untuk tugas pelatihan/inferensi, atur

NCCL_SOCKET_IFNAME=eth0. Ini adalah konfigurasi default dalam citra.Untuk pelatihan node 16-GPU: Secara manual atur

NCCL_SOCKET_IFNAME=hpn0untuk memanfaatkan HPN.

Masalah diketahui

Tidak ada yang dilaporkan.