Topik ini menjelaskan catatan rilis untuk pelatihan-nv-pytorch 25.04.

Fitur utama dan daftar perbaikan bug

Fitur utama

Gambar dasar selaras dengan NGC 25.03, CUDA ditingkatkan ke 12.8.1, dan TransformerEngine ditingkatkan ke 2.1.

Triton diadaptasi ke 3.2.0, accelerate ditingkatkan ke 1.6.0+ali, dengan fitur versi terkait dan perbaikan bug terintegrasi.

vLLM ditingkatkan ke versi komunitas terbaru 0.8.5, flashinfer-python ditingkatkan ke 0.2.5, Transformers ditingkatkan ke 4.51.2+ali, yang mendukung Qwen3.

Perbaikan bug

Tidak ada.

Konten

Skenario | Pelatihan/inferensi |

Kerangka kerja | pytorch |

Persyaratan | NVIDIA Driver release >= 570 |

Komponen inti |

|

Aset

25.04

egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/pelatihan-nv-pytorch:25.04-serverless

Gambar VPC

acs-registry-vpc.{region-id}.cr.aliyuncs.com/egslingjun/{image:tag}

{region-id}menunjukkan wilayah tempat ACS Anda diaktifkan, seperti cn-beijing dan cn-wulanchabu.{image:tag}menunjukkan nama dan tag gambar.

Saat ini, Anda hanya dapat menarik gambar di wilayah China (Beijing) melalui VPC.

egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/pelatihan-nv-pytorch:25.04-serverlessgambar cocok untuk bentuk produk ACS dan bentuk multi-tenant Lingjun, tetapi tidak untuk bentuk single-tenant Lingjun.egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/pelatihan-nv-pytorch:25.04gambar cocok untuk skenario single-tenant Lingjun.

Persyaratan driver

Rilis 25.04 selaras dengan pembaruan versi gambar NGC PyTorch 25.03 (karena NGC merilis gambar pada akhir setiap bulan, pengembangan Golden image hanya dapat didasarkan pada versi NGC bulan sebelumnya). Oleh karena itu, driver Golden-gpu mengikuti persyaratan versi gambar NGC yang sesuai. Rilis ini didasarkan pada CUDA 12.8.1.012 dan memerlukan versi driver NVIDIA 570 atau lebih tinggi. Namun, jika Anda menjalankan GPU pusat data (seperti T4 atau GPU pusat data lainnya), Anda dapat menggunakan versi driver NVIDIA 470.57 (atau lebih tinggi R470), 525.85 (atau lebih tinggi R525), 535.86 (atau lebih tinggi R535), atau 545.23 (atau lebih tinggi R545).

Paket kompatibilitas driver CUDA hanya mendukung driver tertentu. Oleh karena itu, pengguna harus meningkatkan dari semua driver R418, R440, R450, R460, R510, R520, R530, R545, R555, dan R560, yang tidak kompatibel maju dengan CUDA 12.8. Untuk daftar lengkap driver yang didukung, lihat topik Kompatibilitas aplikasi CUDA. Untuk informasi lebih lanjut, lihat Kompatibilitas dan peningkatan CUDA.

Fitur utama dan peningkatan

Optimasi kompilasi PyTorch

Fitur optimasi kompilasi yang diperkenalkan dalam PyTorch 2.0 cocok untuk pelatihan skala kecil pada satu GPU. Namun, pelatihan LLM memerlukan optimasi Memori GPU dan kerangka kerja terdistribusi, seperti FSDP atau DeepSpeed. Akibatnya, torch.compile() tidak dapat memberikan manfaat bagi pelatihan Anda atau memberikan dampak negatif.

Mengontrol granularitas komunikasi dalam kerangka kerja DeepSpeed membantu kompiler mendapatkan grafik komputasi lengkap untuk cakupan optimasi kompilasi yang lebih luas.

PyTorch dioptimalkan:

Frontend kompiler PyTorch dioptimalkan untuk memastikan kompilasi saat terjadi pemutusan grafik apa pun dalam grafik komputasi.

Kemampuan pencocokan mode dan bentuk dinamis ditingkatkan untuk mengoptimalkan kode yang dikompilasi.

Setelah optimasi tersebut, throughput E2E meningkat sebesar 20% saat LLM 8B dilatih.

Optimasi Memori GPU untuk rekompilasi

Kami memperkirakan dan menganalisis konsumsi Memori GPU model dengan menjalankan tes kinerja pada model yang diterapkan di kluster berbeda atau dikonfigurasi dengan parameter berbeda dan mengumpulkan metrik sistem, seperti pemanfaatan Memori GPU. Berdasarkan hasil tersebut, kami menyarankan jumlah optimal lapisan rekompilasi aktivasi dan mengintegrasikannya ke dalam PyTorch. Ini memungkinkan pengguna dengan mudah mendapatkan manfaat dari optimasi Memori GPU. Saat ini, fitur ini dapat digunakan dalam kerangka kerja DeepSpeed.

ACCL

ACCL adalah pustaka komunikasi HPN internal yang disediakan oleh Alibaba Cloud untuk Lingjun. Ini menyediakan ACCL-N untuk skenario akselerasi GPU. ACCL-N adalah pustaka HPN yang disesuaikan berdasarkan NCCL. Ini sepenuhnya kompatibel dengan NCCL dan memperbaiki beberapa bug di NCCL. ACCL-N juga memberikan kinerja dan stabilitas yang lebih tinggi.

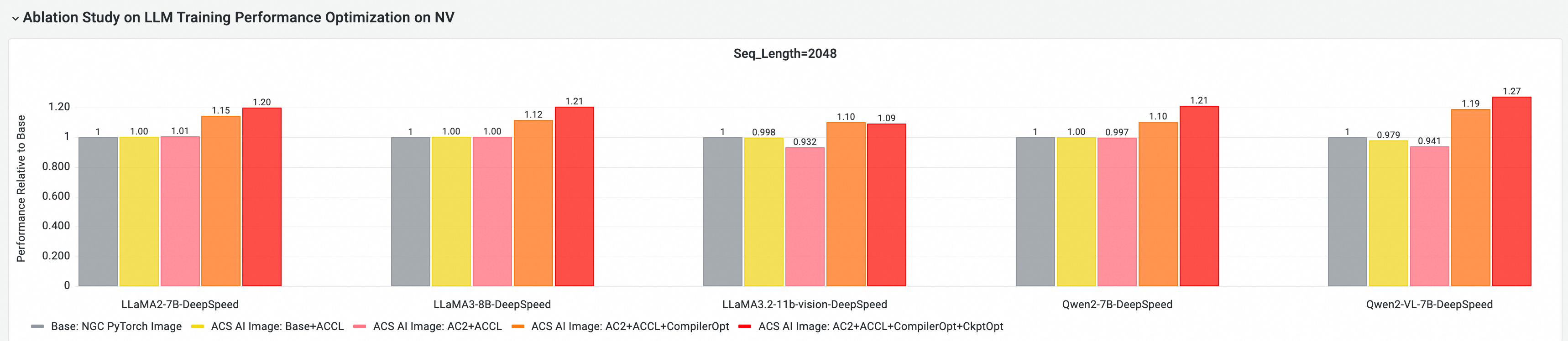

Penilaian manfaat kinerja E2E

Dengan alat penilaian dan analisis kinerja AI cloud-native CNP, kami dapat menggunakan model open source arus utama dan kerangka kerja bersama dengan gambar dasar standar untuk menganalisis kinerja E2E. Selain itu, kami dapat menggunakan studi ablasi untuk lebih menilai bagaimana setiap komponen optimasi memberikan manfaat pada pelatihan model secara keseluruhan.

Analisis Kontribusi Kinerja E2E Komponen Inti GPU

Tes berikut didasarkan pada Golden-25.04, melakukan evaluasi kinerja E2E dan analisis komparatif pada kluster GPU multi-node, dengan item perbandingan termasuk yang berikut:

Dasar: Gambar PyTorch NGC

Gambar AI ACS: Base+ACCL: Gambar menggunakan pustaka komunikasi ACCL

Gambar AI ACS: AC2+ACCL: Gambar Golden menggunakan AC2 BaseOS, tanpa mengaktifkan optimasi apa pun

Gambar AI ACS: AC2+ACCL+CompilerOpt: Gambar Golden menggunakan AC2 BaseOS, dengan hanya optimasi kompilasi torch yang diaktifkan

Gambar AI ACS: AC2+ACCL+CompilerOpt+CkptOpt: Gambar Golden menggunakan AC2 BaseOS, dengan optimasi kompilasi torch dan optimasi titik kontrol gradien selektif diaktifkan

Memulai Cepat

Contoh berikut hanya menggunakan Docker untuk menarik gambar pelatihan-nv-pytorch.

Untuk menggunakan gambar pelatihan-nv-pytorch di ACS, Anda harus menariknya dari halaman pusat artefak konsol tempat Anda membuat beban kerja atau menentukan gambar dalam file YAML.

1. Pilih gambar

docker pull egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/pelatihan-nv-pytorch:[tag]2. Panggil API untuk mengaktifkan optimasi kompilasi dan optimasi Memori GPU untuk rekompilasi

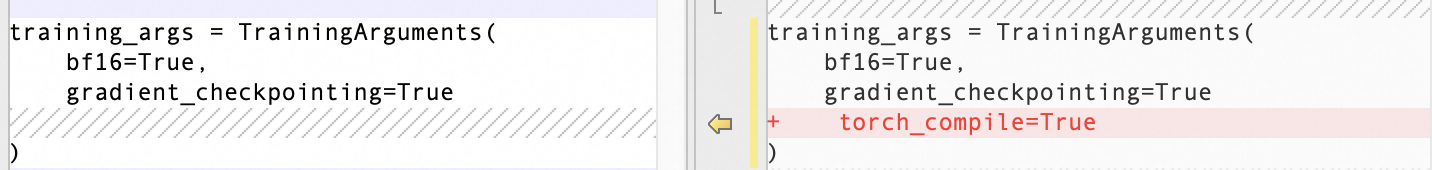

Aktifkan Optimasi Kompilasi

Gunakan API Trainer transformers:

Aktifkan Optimasi Memori GPU untuk Rekompilasi

export CHECKPOINT_OPTIMIZATION=true

3. Jalankan kontainer

Gambar ini menyediakan alat pelatihan model bawaan bernama ljperf untuk menunjukkan prosedur menjalankan kontainer dan menjalankan tugas pelatihan.

LLM

# Jalankan kontainer dan masuk ke kontainer.

docker run --rm -it --ipc=host --net=host --privileged egslingjun-registry.cn-wulanchabu.cr.aliyuncs.com/egslingjun/pelatihan-nv-pytorch:[tag]

# Jalankan demo pelatihan.

ljperf benchmark --model deepspeed/llama3-8b 4. Saran

Perubahan dalam gambar melibatkan pustaka PyTorch dan DeepSpeed. Jangan instal ulang.

Biarkan

zero_optimization.stage3_prefetch_bucket_sizedalam konfigurasi DeepSpeed kosong atau atur keauto.

Masalah yang diketahui

Gambar ditingkatkan ke PyTorch 2.6, dan manfaat kinerja optimasi memori rekompilasi untuk model tipe LLM tidak sebaik gambar sebelumnya. Optimasi berkelanjutan sedang berlangsung.