日志服务提供可托管、可扩展、高可用的数据加工服务。数据加工服务可用于数据的规整、富化、流转、脱敏和过滤。

加工流程

数据加工服务通过如下三个步骤完成加工处理。

通过协同消费组对源LogStore的数据进行读取。

通过加工规则对读取到的每一条数据进行加工处理。

将加工后的数据写入目标LogStore。

数据加工完成后,您可以在目标LogStore中查看加工后的数据。

功能特性

日志服务提供数据加工功能,用于数据的规整、富化、流转、脱敏和过滤。具体说明如下:

数据规整:针对混乱格式的日志进行字段提取、格式转换,获取结构化数据以支持后续的流处理、数据仓库计算。

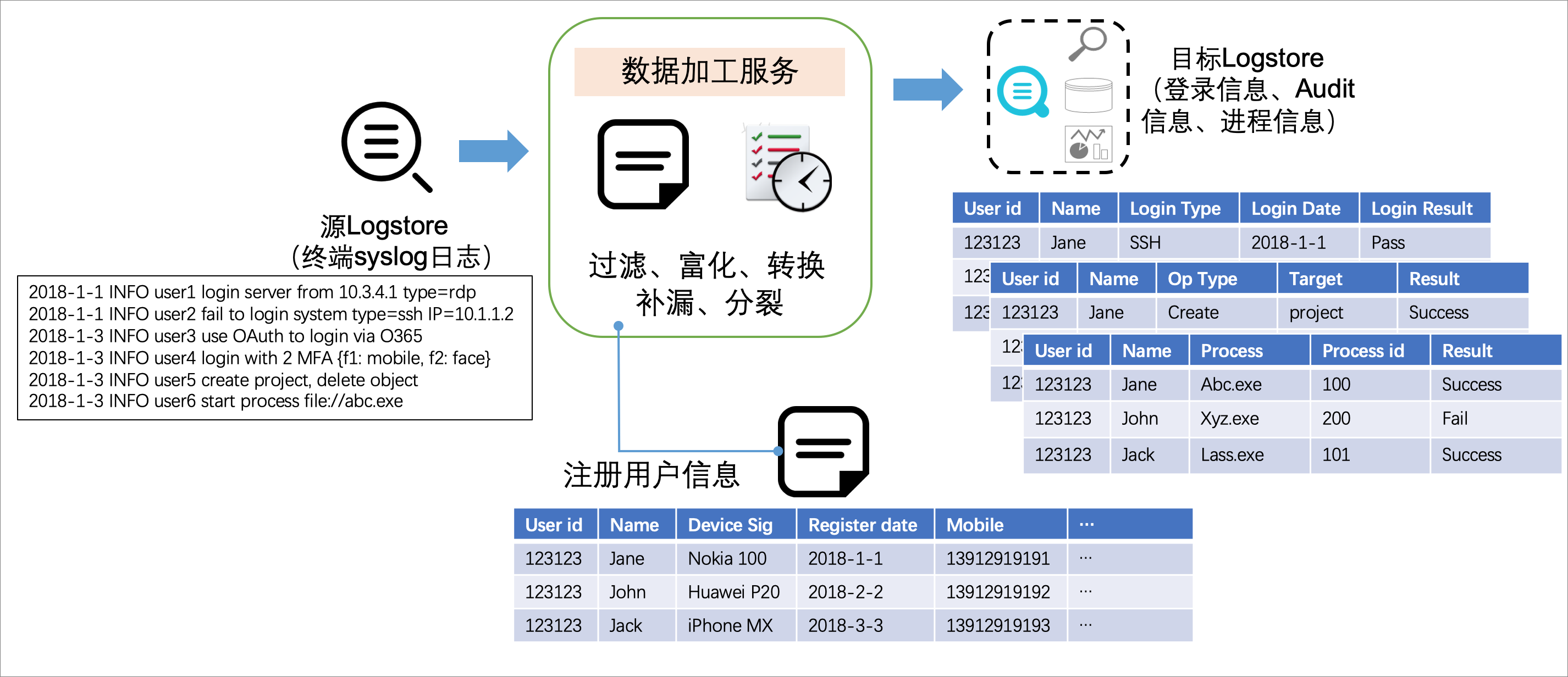

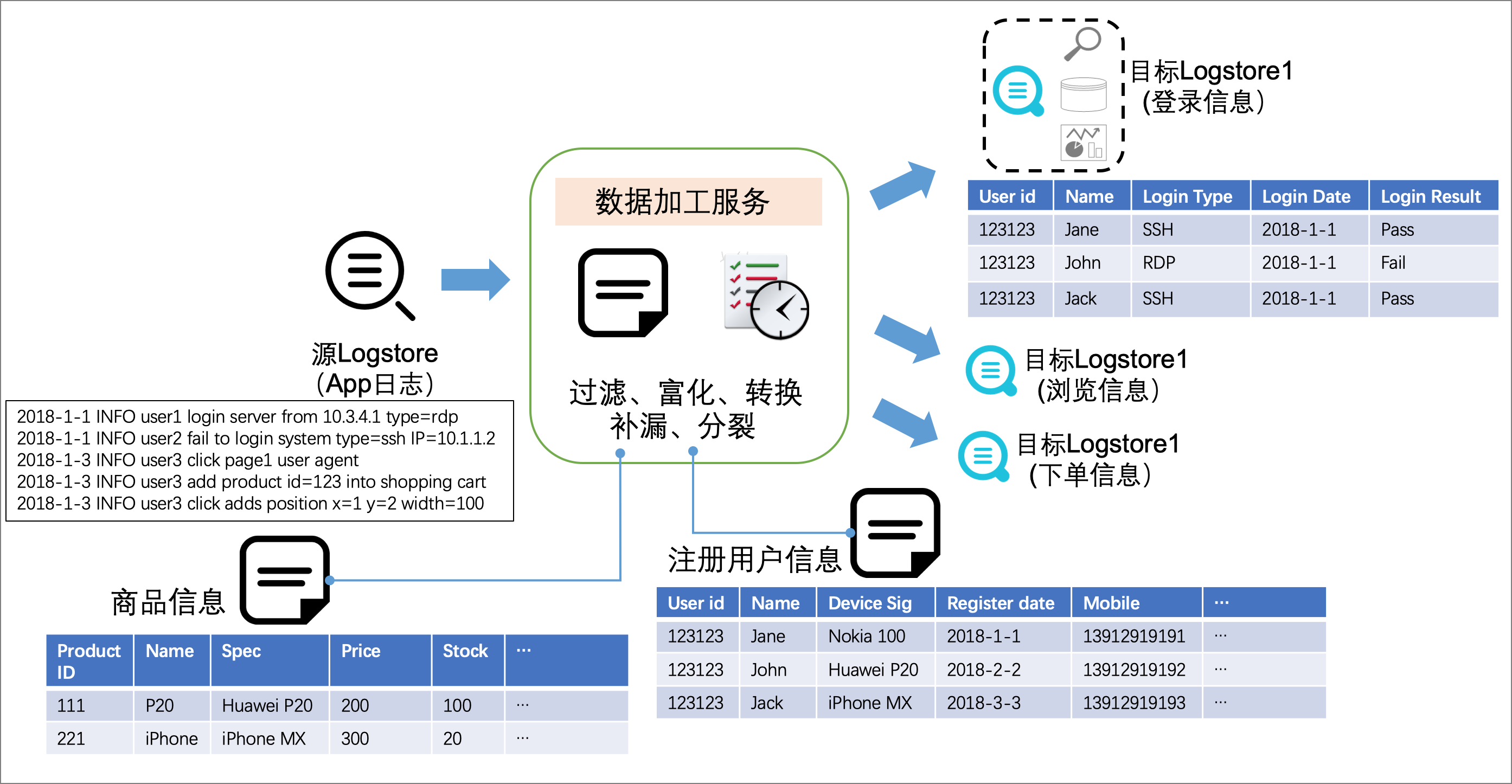

数据富化:对日志(例如订单日志)和维表(例如用户信息表)进行字段连接(JOIN),为日志添加更多维度的信息,用于数据分析。

数据流转:通过跨地域加速功能将海外地域的日志传输到中心地域,实现全球日志集中化管理。

数据脱敏:对数据中包含的密码、手机号、地址等敏感信息进行脱敏。

数据过滤:过滤出关键服务的日志,用于重点分析。

适用场景

数据规整(一对一):从源LogStore中读取日志数据,进行加工后输出到目标LogStore中。

数据分派(一对多):从源LogStore中读取日志数据,进行加工后分别输出到不同的目标LogStore中。

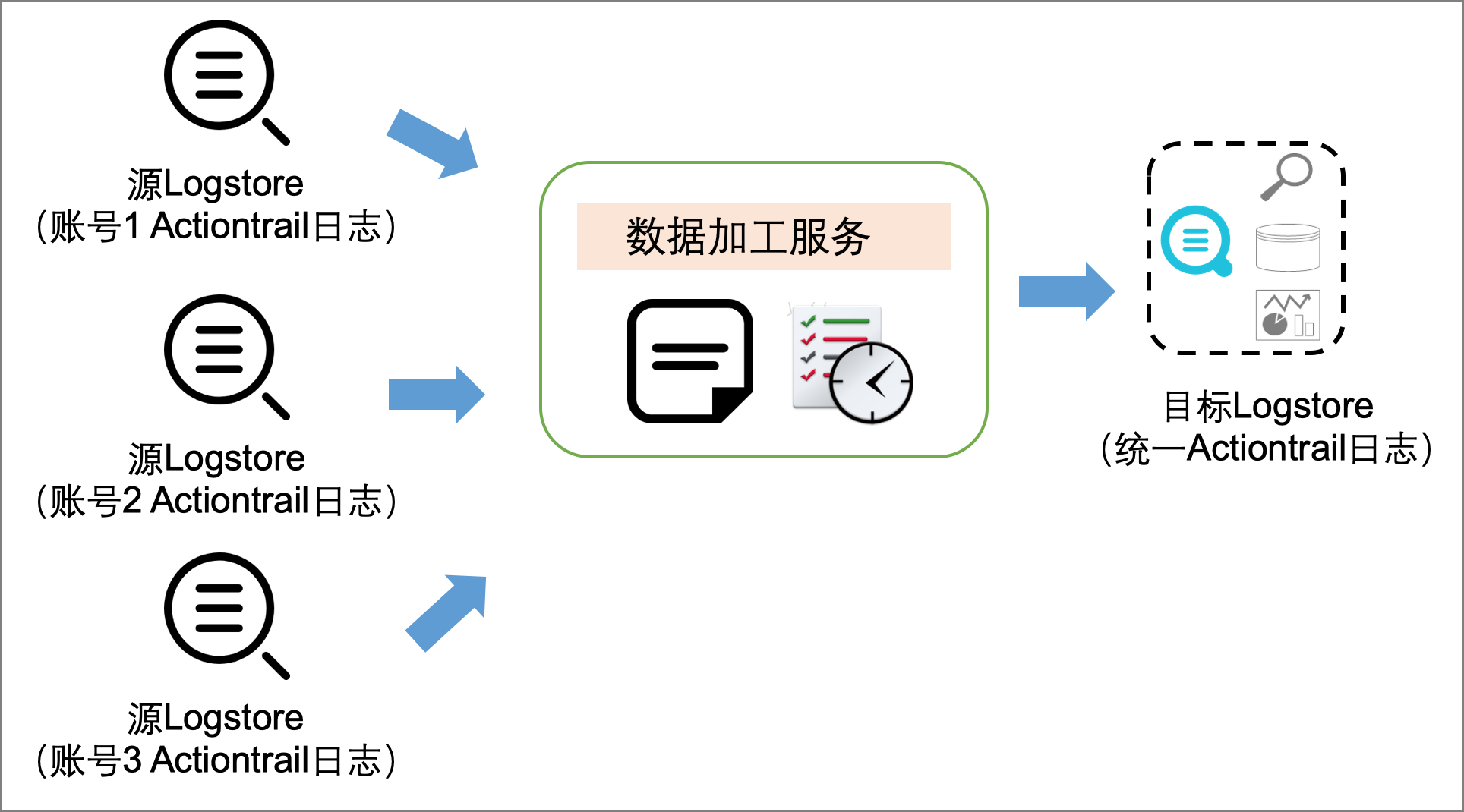

数据融合(多对一):分别从不同的源LogStore中读取日志数据,进行加工后输出到目标LogStore中。

加工语法

SLS DSL(Domain Specific Language)提供了200多个内置函数以及400多个正则表达式模式。更多信息,请参见语法简介 。

优势

SLS DSL自由编排,包括过滤、规整、富化、流转、脱敏等。

实时处理、数据秒级可见、计算能力扩展、按量弹性伸缩、高吞吐能力。

面向日志分析场景,提供开箱即用的函数。

提供实时仪表盘、异常日志和告警集成功能。

全托管、免运维,与阿里云大数据产品、开源生态集成。

费用说明

若LogStore的计费模式为按写入数据量计费时,数据加工服务不产生费用,仅从日志服务公网域名所在接口拉取数据时,会产生外网读取流量(按照压缩后的数据量计算)。具体内容,可参见按写入数据量计费模式计费项。

若LogStore的计费模式为按使用功能计费时,数据加工服务会消耗机器与网络资源产生相应费用。更多信息,请参见按使用功能计费模式计费项。

您可以根据实际情况关闭源LogStore的索引,并设置较短的日志数据保存时间,以节省费用。更多信息,请参见性能指南和成本优化指南。