DeepSeek-R1是由深度求索公司推出的首款推理模型,該模型在數學、代碼和推理任務上的表現優異。深度求索不僅開源了DeepSeek-R1模型,還發布了從DeepSeek-R1基於Llama和Qwen蒸餾而來的六個密集模型,在各項基準測試中均表現出色。本文以蒸餾模型DeepSeek-R1-Distill-Qwen-7B為例,為您介紹如何微調該系列模型。

支援的模型列表

PAI-Model Gallery支援六種蒸餾模型的LoRA監督微調訓練,下表中給出了在預設參數和資料集的情況下,所推薦的最低配置:

蒸餾模型 | 基模型 | 支援的訓練方式 | 最低配置 |

DeepSeek-R1-Distill-Qwen-1.5B | LoRA 監督微調 | 1卡A10(24 GB顯存) | |

DeepSeek-R1-Distill-Qwen-7B | 1卡A10(24 GB顯存) | ||

DeepSeek-R1-Distill-Llama-8B | 1卡A10(24 GB顯存) | ||

DeepSeek-R1-Distill-Qwen-14B | 1卡GU8IS(48 GB顯存) | ||

DeepSeek-R1-Distill-Qwen-32B | 2卡GU8IS(48 GB顯存) | ||

DeepSeek-R1-Distill-Llama-70B | 8卡GU100(80 GB顯存) |

訓練模型

進入Model Gallery頁面。

登入PAI控制台。

在頂部左上方根據實際情況選擇地區。

在左側導覽列選擇工作空間列表,單擊指定工作空間名稱,進入對應工作空間。

在左側導覽列選擇快速開始 > Model Gallery。

在Model Gallery頁面右側的模型列表中,單擊DeepSeek-R1-Distill-Qwen-7B模型卡片,進入模型詳情頁面。

該頁麵包含模型訓練、部署的詳細資料,比如SFT監督微調資料格式的說明以及模型調用方式。

單擊右上方訓練。關鍵配置如下:

資料集配置:當完成資料的準備,您可以將資料上傳到Object Storage Service Bucket中。

計算資源配置:選擇合適的資源,預設配置下所需的最低機型配置見支援的模型列表,如果對參數進行了調整,可能需要更大顯存規格。

超參數配置:LoRA監督微調支援的超參資訊如下,您可以根據使用的資料,計算資源等調整超參。具體操作,請參見大語言模型微調指引。

超參數

類型

預設值(以7B為例)

描述

learning_rate

float

5e-6

學習率,用於控制模型權重的調整幅度。

num_train_epochs

int

6

訓練資料集被重複使用的次數。

per_device_train_batch_size

int

2

每個GPU在一次訓練迭代中處理的樣本數量。較大的批次大小可以提高效率,也會增加顯存的需求。

gradient_accumulation_steps

int

2

梯度累積步驟數。

max_length

int

1024

模型在一次訓練中處理的輸入資料的最大token長度。

lora_rank

int

8

LoRA維度。

lora_alpha

int

16

LoRA權重。

lora_dropout

float

0

LoRA訓練的丟棄率。通過在訓練過程中隨機丟棄神經元,來防止神經網路過擬合。

lorap_lr_ratio

float

16

LoRA+ 學習率比例(λ = ηB/ηA)。ηA, ηB分別是adapter matrices A與B的學習率。相比於 LoRA,LoRA+可以為過程中的關鍵區段使用不同的學習率來實現更好的效能和更快的微調,而無需增加計算需求。當lorap_lr_ratio設為0時,表示使用普通的LoRA而非LoRA+。

單擊訓練,Model Gallery自動跳轉到模型訓練頁面,並開始進行訓練,您可以查看訓練任務狀態和訓練日誌。

如果訓練任務成功,訓練好的模型會自動註冊到AI資產-模型管理中,您可以查看或部署對應的模型,詳情請參見註冊及管理模型。

如果訓練任務失敗,可單擊任務狀態的

查看失敗原因,也可以去任務日誌頁面查看更多錯誤資訊。關於常見的訓練錯誤及解決方案請參見常見問題、Model Gallery常見問題。

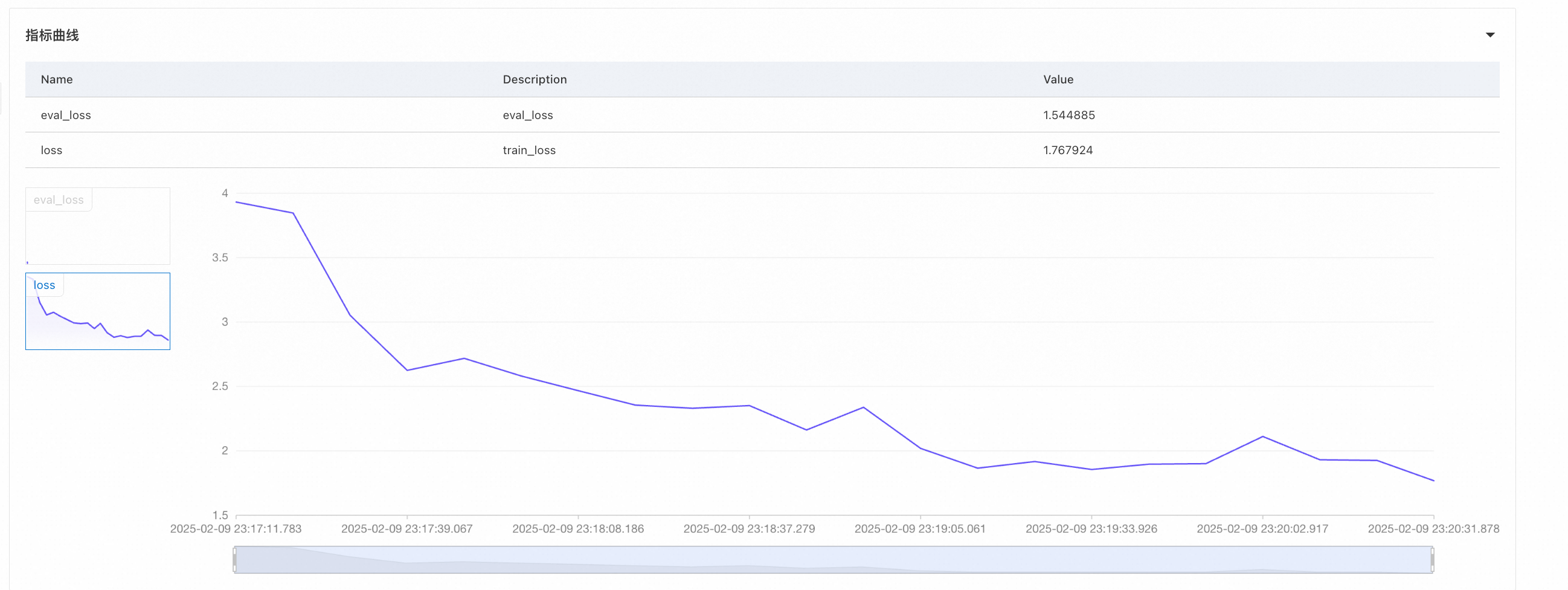

查看失敗原因,也可以去任務日誌頁面查看更多錯誤資訊。關於常見的訓練錯誤及解決方案請參見常見問題、Model Gallery常見問題。在訓練頁面下方的指標曲線地區,可以查看訓練中loss的變化。

待訓練成功後,單擊右上方部署,即可將訓練好的模型部署為EAS服務。部署完畢的模型的調用方式與原來的蒸餾模型一致,可參考模型詳情頁或一鍵部署DeepSeek-V3、DeepSeek-R1模型。

關於費用

在Model Gallery中操作模型訓練,是使用的DLC的訓練能力。DLC按照任務訓練時間長度來收費,您有訓練任務在運行,對應就會有資源消耗;訓練任務運行完成,就不會有資源消耗了,不需要手動關機。計費詳情請參見分布式訓練(DLC)計費說明。

常見問題

訓練任務失敗排查

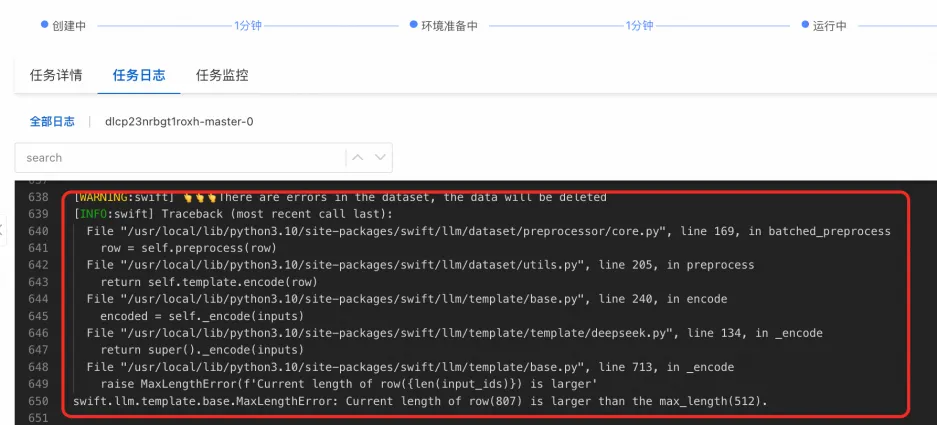

訓練時請設定合適的 max_length(訓練配置中的超參),訓練演算法中會對超過 max_length 的資料直接進行刪除,並在任務日誌中列印如下內容:

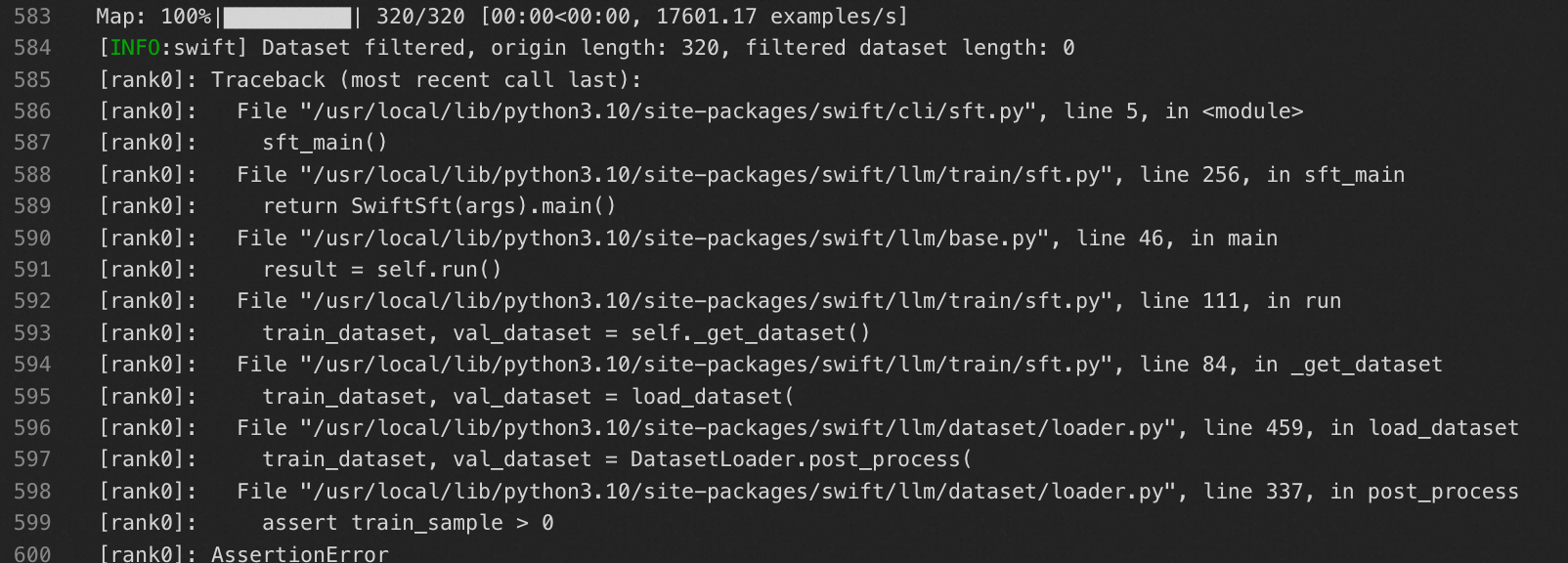

有可能會出現刪除資料過多導致訓練/驗證資料集為空白,導致訓練任務失敗的情況:

有可能會出現刪除資料過多導致訓練/驗證資料集為空白,導致訓練任務失敗的情況:

出現以下錯誤記錄檔:failed to compose dlc job specs, resource limiting triggered, you are trying to use more GPU resources than the threshold,是因為訓練任務當前限制最多同時運行2*GPU,超過會觸發資源限制。請等待正在運行中的訓練任務完成再啟動,或提交工單申請增加配額。

出現以下錯誤記錄檔:the specified vswitch vsw-**** cannot create the required resource ecs.gn7i-c32g1.8xlarge, zone not match。這是因為部分規格在交換器所在可用性區域沒有資源了。您可以嘗試以下方式解決:1. 不選擇交換器(DLC後端會自己根據庫存選擇對應可用性區域的交換器)2. 切換其他資源規格。

訓練後模型可以下載嗎?

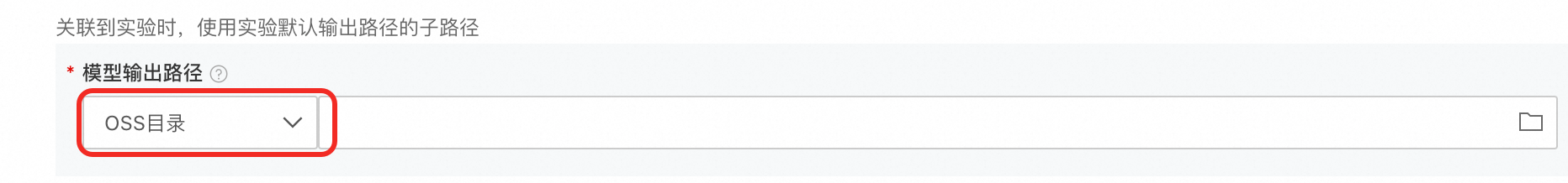

建立訓練任務時,支援設定模型輸出路徑到OSS目錄,然後您可以從OSS下載到本地。